Hadoop telah menjadi salah satu framework yang paling banyak digunakan untuk memproses dan menganalisis big data di berbagai aplikasi. Kemampuannya untuk memberikan skalabilitas, toleransi kesalahan, dan efisiensi pemrosesan menjadikannya solusi ampuh untuk tantangan data penting yang dihadapi organisasi modern.

Daftar Isi

ToggleHadoop Adalah

Hadoop adalah dunia open source yang revolusioner untuk pemrosesan data besar. Dikembangkan pada awal tahun 2000-an oleh Doug Cutting dan Mike Cafarella, awalnya berdasarkan penelitian mereka pada sistem file terdistribusi Google (Google File System) dan program MapReduce. Kerangka kerja ini diciptakan untuk memecahkan masalah volume dan kompleksitas pemrosesan data yang menjadi semakin penting akibat ledakan informasi di era digital. Hadoopmemungkinkan organisasi untuk menyimpan, mengelola, dan menganalisis data dalam jumlah besar secara efisien dan dalam skala besar menggunakan infrastruktur terdistribusi.

Komponen utama ekosistem adalah Sistem File Terdistribusi Hadoop (HDFS), yang memungkinkan data disimpan dan diakses secara terdistribusi ke beberapa komputer dalam cluster Hadoop. Dengan HDFS, sejumlah besar data dipecah menjadi bagian-bagian yang lebih kecil dan didistribusikan ke seluruh cluster, memberikan toleransi kesalahan yang lebih besar dan membuat data lebih cepat dan efisien. Selain itu, model pemrograman MapReduce memungkinkan pemrosesan data, mempercepat analisis data, dan memungkinkan aplikasi memanfaatkan infrastruktur komputasi besar. Selain kemampuannya, Hadoop telah menjadi andalan analisis data, yang digunakan dalam aplikasi mulai dari analisis web hingga analisis keuangan.

Komponen Utama Hadoop

Komponen utama yang dapat anda gunakan bisa menjadi hal baik dalam pengoperasiannya

1. Sistem penyimpanan terdistribusi HDFS

Adalah sistem file terdistribusi yang dirancang untuk menyimpan data dalam jumlah besar di cluster Hadoop. Data dalam HDFS dibagi menjadi beberapa bagian yang lebih kecil (misalnya 128 MB atau 256 MB) dan disimpan dalam format terdistribusi di beberapa cluster. HDFS dirancang untuk memberikan toleransi kesalahan untuk menyalin data antar lokasi guna mencegah kehilangan data karena kegagalan perangkat keras.

2. MapReduce

MapReduce adalah model pemrograman yang digunakan untuk memproses dan mendistribusikan data secara paralel dalam cluster Hadoop. Model ini terdiri dari dua fase utama: fase “pemetaan” untuk pemrosesan data dan fase “pengurangan” untuk mengumpulkan hasil dari jaringan. MapReduce membuat pemrosesan data dalam kerangka lebih efisien dengan mendistribusikan tugas komputasi di beberapa lokasi.

3. Yet Another Resource Negotiator (YARN)

YARN adalah manajer sumber daya di cluster Hadoop yang bertanggung jawab untuk mengelola dan mengalokasikan sumber daya komputasi (CPU, memori, dll.) di dalam cluster untuk pemrosesan aplikasi. YARN menyediakan cara yang efisien untuk memanfaatkan sumber daya dalam lingkungan bersama di mana beberapa aplikasi dapat berbagi cluster yang sama.

Baca juga: 6 Fitur Data Warehousing

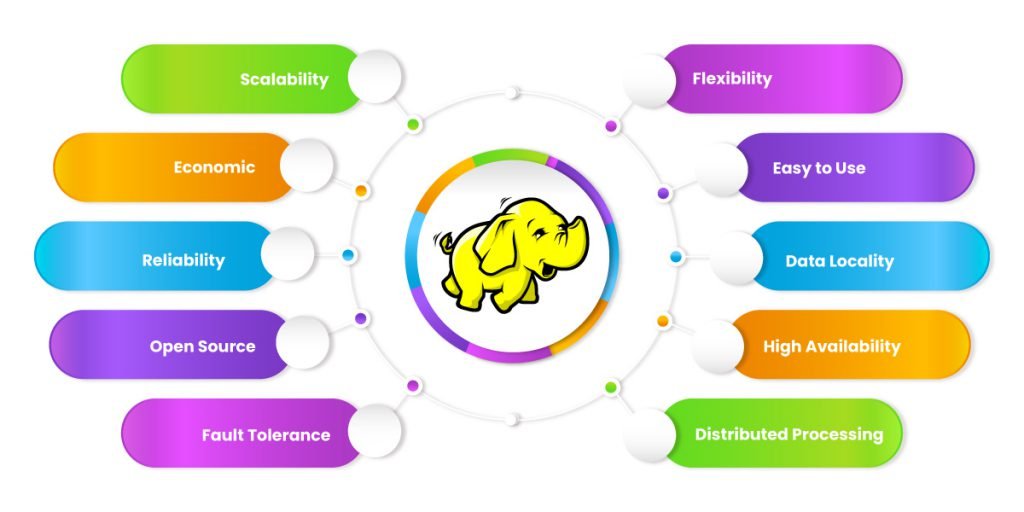

Keunggulan Hadoop

Memiliki banyak keunggulan yang menjadikannya pilihan populer untuk memproses dan menganalisis data besar. Beberapa manfaat utama adalah

1. Skalabilitas Tinggi

Dirancang untuk bekerja pada skala yang sangat besar. Hal ini memungkinkan pengguna dengan mudah menambahkan lebih banyak node ke cluster Hadoop seiring meningkatnya kapasitas komputasi dan penyimpanan. Berkat pemrosesan terdistribusi dan paralel, Hadoop dapat mengelola data secara efisien dari berbagai sumber dan memberikan kinerja yang andal bahkan ketika volume data terus bertambah.

2. Toleransi Kesalahan

Hadoop menggunakan replikasi data antar node untuk memberikan toleransi kesalahan. Jika komputer rusak atau data rusak, Hadoop dapat secara otomatis mendeteksi masalah dan menggunakan salinan data dari sumber lain untuk memulihkan data. Hal ini membuat Hadoop sangat andal dan cocok untuk lingkungan di mana kemungkinan besar terjadi kegagalan perangkat keras.

3. Efisiensi Pemrosesan paralel

Model pemrograman MapReduce yang digunakan oleh Hadoop menyediakan cara untuk memproses data pada tingkat komputasi. Proses pencocokan dan pengurangan dapat didistribusikan ke berbagai area, memungkinkan aplikasi memberikan hasil lebih cepat dibandingkan proses tradisional satu-ke-satu atau terpusat.

4. Terjangkau

Berjalan pada infrastruktur terdistribusi yang dapat dibangun dengan perangkat keras komoditas. Artinya biaya pembuatan dan pengelolaan cluster Hadoop bisa lebih murah dibandingkan dengan solusi cluster yang mahal. Pengguna dapat menggunakan alat berbiaya rendah dan mudah digunakan untuk memperluas infrastruktur cluster Hadoop sesuai kebutuhan.

5. Kaya Ekosistem

Ini memberikan fleksibilitas kepada pengguna Hadoop untuk memilih alat dan teknologi yang sesuai dengan kebutuhan analisis data mereka. Selain itu, Dapat digunakan dalam berbagai aplikasi dan kasus penggunaan, mulai dari analisis data hingga analisis waktu nyata.

Baca juga: Mengenal Data Lake: Fitur dan Fungsinya

Tantangan Hadoop

Mempelajari Hadoop memang menyenangkan, tetapi juga membutuhkan pemahaman mendalam tentang konsep dan teknologi yang terlibat. Berikut beberapa masalah yang mungkin Anda temui saat mempelajari

1. Memahami Konsep

Salah satu tantangan utama mempelajari Hadoop adalah memahami konsep pada tingkat ini. Hadoop menggunakan pendekatan terdistribusi untuk menyimpan dan memproses data di tingkat komputer. Hal ini melibatkan pemahaman bagaimana data didistribusikan, direplikasi, dan dikirim ke berbagai node di cluster. Memahami konsep ini memerlukan perubahan paradigma dari entri data ke pemrosesan dataterdistribusi.

2. Mengembangkan Lingkungan Pengembangan

Memiliki lingkungan Hadoop yang sukses dapat menjadi tantangan, terutama jika Anda baru mengenal teknologi ini. Menyiapkan cluster Hadoop lokal atau menggunakan alat virtualisasi seperti Docker atau VirtualBox memerlukan pengetahuan teknis tentang instalasi dan konfigurasi perangkat lunak. Selain itu, pengaturan ini mungkin memerlukan penanganan masalah kompatibilitas dan struktural yang kompleks.

3. Memahami Komponen Dasar

Terdiri dari beberapa komponen dasar seperti Hadoop Distributed File System (HDFS), MapReduce, dan YARN. Memahami peran dan fungsi masing-masing komponen dalam ekosistem Hadoop memerlukan kajian mendalam tentang bagaimana mereka berinteraksi dan bekerja sama dalam mengolah data. Tantangan ini dapat diatasi dengan memprogram MapReduce dan menggunakan alat seperti Hive atau Spark.

4. Manajemen dan Pemantauan

Saat mempelajari Hadoop, penting untuk memahami manajemen dan pemantauan cluster. Hal ini mencakup pemahaman cara mengelola sumber daya komputasi dalam sebuah cluster menggunakan YARN, memantau kesehatan sistem dan operasi, dan memecahkan masalah gangguan atau kesalahan apa pun yang mungkin terjadi dalam operasi sehari-hari.

5. Pemrograman dan Analisis Data Terdistribusi

Memungkinkan pemrosesan data secara terdistribusi menggunakan model pemrograman MapReduce atau alat-alat analisis data lainnya dalam ekosistem. Tantangan dalam hal ini termasuk pembelajaran tentang cara menulis program MapReduce yang efisien, menerapkan algoritma paralel, dan menganalisis data besar menggunakan alat seperti Hive atau Spark SQL.

Meskipun tantangan-tantangan ini mungkin menantang, mempelajari Hadoop juga bisa sangat bermanfaat karena membuka pintu lebih dalam untuk memahami data besar dan teknologi pemrosesan. Memiliki keterampilan dapat memperluas peluang karir di bidang analisis data dan teknologi informasi, yang banyak diminati saat ini.

Kesimpulan

Analisis web, analisis bisnis, pemrosesan dokumen besar, dll. Ini banyak digunakan dalam berbagai aplikasi untuk menganalisis data yang besar dan kompleks seperti Keunggulan utama antara lain dapat didistribusikan, terukur, dan toleran terhadap kesalahan. Hal ini membuatnya ideal untuk memecahkan masalah terkait data besar. Menggunakan Hadoop memungkinkan perusahaan memproses data besar dengan biaya yang jauh lebih rendah dibandingkan solusi tradisional karena memanfaatkan infrastruktur komoditas untuk menghasilkan komputasi berkinerja tinggi. Hal ini menjadikan salah satu platform terpenting untuk analisis data saat ini. Jika anda tertarik anda dapat mnegikuti Kelas Data science